Open Interpreterの使い方や料金を徹底解説!実際にアンケート結果のデータ分析をした活用事例を紹介!

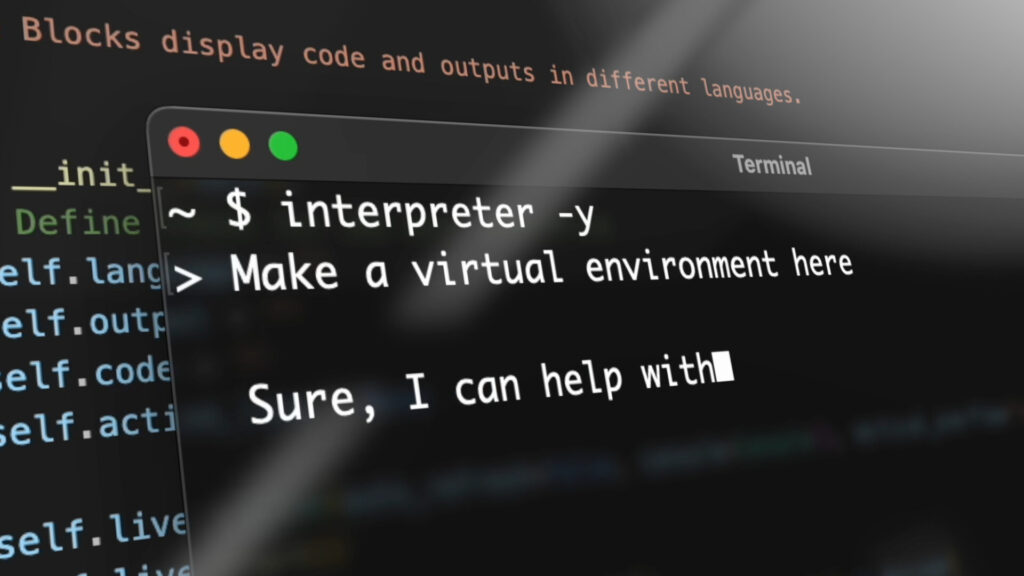

「Open Interpreter」は、GPT-3.5、GPT-4、Code Llamaなどの大規模言語モデル(LLMs)を駆使して開発された、先進的かつ多目的に使えるオープンソースツールです

このツールを使用することで、自然言語による対話を介して、ローカル環境でデータ分析やプログラミング作業を行うことが可能になります。

本ページでは、Open Interpreterの始め方や使い方に加え、実際にこのツールを使ってデータ分析を行った過程を紹介しています。

Open Interpreterとは

Open Interpreterは、GPT-3.5、GPT-4、Code Llamaなどの大規模言語モデル(LLMs)を活用して開発されたオープンソースのツールです。

このツールは、OpenAIが提供するChatGPTの「Advanced Data Analysis(旧Code Interpreter)」のオープンソース版とも言える存在で、自然言語による対話を通じてプログラミングをローカル環境で実行することができます。

このツールの最大の特徴は、ChatGPTの「Advanced Data Analysis」と違いローカル環境で動くため、ファイル容量やネット接続への制約がなく、ChatGPTの「Advanced Data Analysis」より幅広い使い方ができます。

そのため、Open Interpreterを使えば、プログラミングの知識がない方でも、Chromeブラウザでのリサーチ、大量データの分析など、多岐にわたる作業をチャット形式で簡単に行うことができます。

Open Interpreterの料金

Open Interpreterはオープンソースのため無料で利用可能ですが、GPTを使って動かす際には、OpenAI APIの使用料がかかります。

無料で使用したい場合は、Code-Llamaのような無料APIの利用が必要です。

Open Interpreterの始め方

Open Interpreterは特別な登録が不要で、インストールするだけで直ちに使えます。

公式から提供されている詳しい解説付きのクイックスタート用Google Colabも公開されており、手軽に試したい方には、このコードを参考にすることをおすすめします。

1. インストール

1pip install open-interpreterターミナルで次のコマンドを実行して、Open Interpreter をインストールします。

2. 対話型チャットの開始

インストール後、次のコマンドを実行して、ターミナルで対話型チャットを開始できます。

1interpreterPython で対話型チャットを開始するには、次のコマンドを実行します。

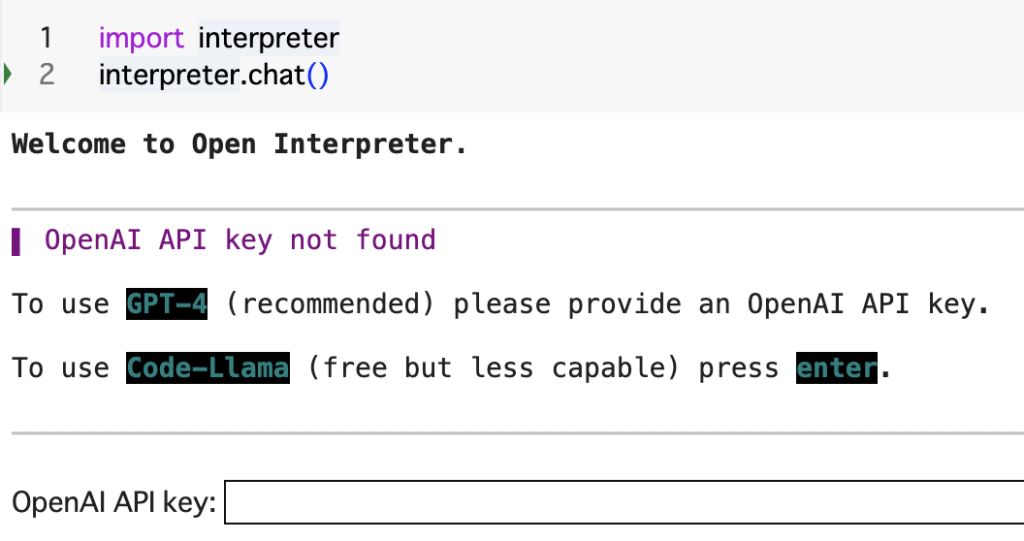

1import interpreter

2interpreter.chat()

2. OpenAI APIキーの設定

OpenAIのAPIキーを利用する場合は設定が必要ですが、OpenAIのキーを使用しない場合は、Code-Llamaを利用することができます。

これで、Open Interpreterを利用する準備が整いました。

Open Interpreterの使い方

タスクの依頼・実行

Open Interpreterに対話形式で指示を出すことで、様々なタスクを行ってもらうことができます。

チャットを開始するには、次のコマンドを実行します。

ターミナルでは、以下のコマンドで対話型チャットを開始できます。

1interpreterPython 対話型チャットを開始するには、次のコマンドを実行します。

1import interpreter

2interpreter.chat()

これにより、例えば、以下のようにローカルに保存されているファイルの分析を依頼することができます。

チャット形式以外にも、特定のメッセージを直接 .chat(message) に渡してコマンドを実行することも可能です。

1interpreter.chat(u0022Add subtitles to all videos in /videos.u0022)新しいチャットの開始

ターミナルでは、Open Interpreterは以前の会話を記憶しません。

そのため、新しいチャットを開始するにはinterpreterを実行して新しいチャットを開始するだけです。

1interpreterPythonでは、Open Interpreterが会話履歴を記憶するので、新しくチャットを始めたい場合は、以下のコマンドでリセットできます。

1interpreter.reset()チャットの保存と復元

ターミナルでは、Open Interpreterによって以前の会話が <your application directory>/Open Interpreter/conversations/ に保存されます。

--conversationsを実行すると、以前の会話が表示されるので、矢印キーを使用して1つを選択し、ENTERを押して再開します。

1interpreter --conversationsPythonではinterpreter.messages = messagesで、会話を再開することができます。

1# Save messages to 'messages'

2messages = interpreter.chat("My name is Killian.")

3

4# Reset interpreter ("Killian" will be forgotten)

5interpreter.reset()

6

7# Resume chat from 'messages' ("Killian" will be remembered)

8interpreter.messages = messages

モデルの変更

Open Interpreter は、LiteLLM を使用してホストされた言語モデルに接続します。

ターミナルでは、モデルパラメータを設定することでモデルを変更できます。

1interpreter --model gpt-3.5-turbo

2interpreter --model claude-2

3interpreter --model command-nightly

Pythonでは、オブジェクトにモデルを設定することでモデルを変更できます。

1interpreter.llm.model = "gpt-3.5-turbo"ローカルモデルで使う方法(API課金しない方法)

Open Interpreterは、PT-4やGPT-3.5などのホスト型言語モデルとCode Llamaなどのローカル言語モデルの両方に対応しています。

ホスト型モデルは高速で機能的ですが、使用には費用が発生します。

一方、ローカルモデルは無料で使用できますが、セットアップが複雑なことがあります。

そのため、ホスト型モデルでOpen Interpreterの機能を確認し、その後でローカルモデルに切り替えることをおすすめします。

ターミナルでローカルモデルを使う方法

Open Interpreter は、LM Studio を使用してローカル言語モデルに接続するので、ターミナルでは以下のコマンドを実行するだけです

1interpreter --localまた、LM Studio をバックグラウンドで実行する必要があります。

- https://lmstudio.ai/ をダウンロードして起動します。

- モデルを選択し、「ダウンロード」をクリックします。

- 上部でモデルを選択し、サーバーの開始 をクリックします。

サーバーが実行されたら、Open Interpreter との会話を開始できます。

(コマンド interpreter --local を実行すると、上記の手順が表示されます。)

Pythonでローカルモデルを使う方法

Pythonパッケージを使用すると、各設定をより詳細に制御できます。

--local を複製して LM Studio に接続するには、次の設定を使用します。

1from interpreter import interpreter

2

3interpreter.offline = True # Disables online features like Open Procedures

4interpreter.llm.model = "openai/x" # Tells OI to send messages in OpenAI's format

5interpreter.llm.api_key = "fake_key" # LiteLLM, which we use to talk to LM Studio, requires this

6interpreter.llm.api_base = "http://localhost:1234/v1" # Point this at any OpenAI compatible server

7

8interpreter.chat()

また、公式の情報ではないですが、具体的な設定方法は以下の記事も参考になります。

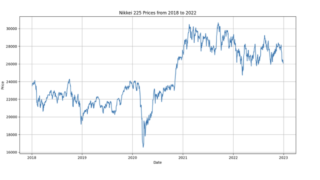

[活用事例]アンケートデータの分析

Open Interpreterの実力を試すべく、アンケート結果の分析とその結果をまとめた調査レポートの作成を行ってみます。

この作業は慣れない人がExcelで行うとすると、1~2時間はかかる作業です。

今回分析に使用したGoogle colabは以下に公開しておきます

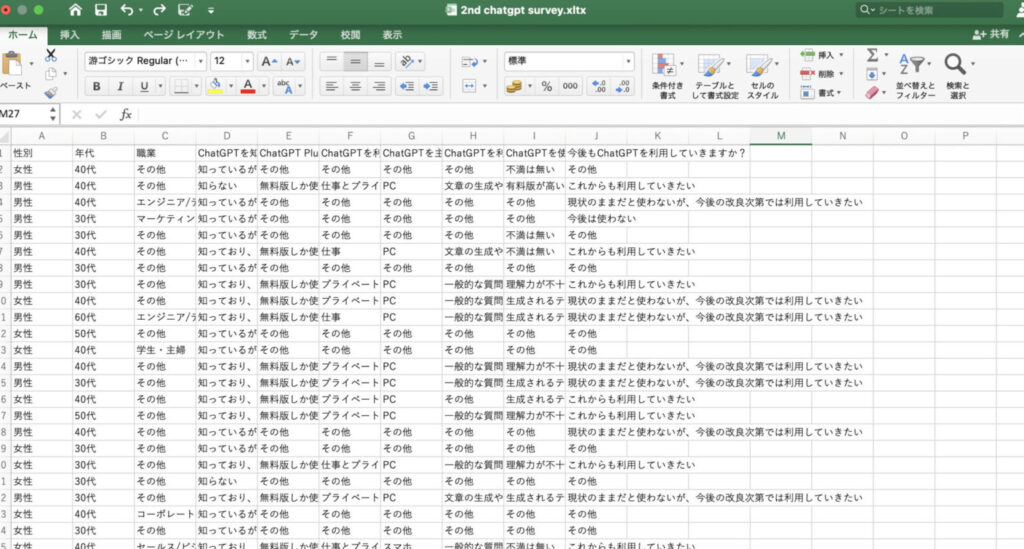

分析に利用したデータ

今回、分析に用いたデータは「ChatGPTの利用傾向」についてのアンケート結果はこちらです。

データの形式としては一般的なアンケート結果と同様のため、他のアンケート結果を分析する際も、今回のChatGPTを使用した手法が参考になるかと思います。

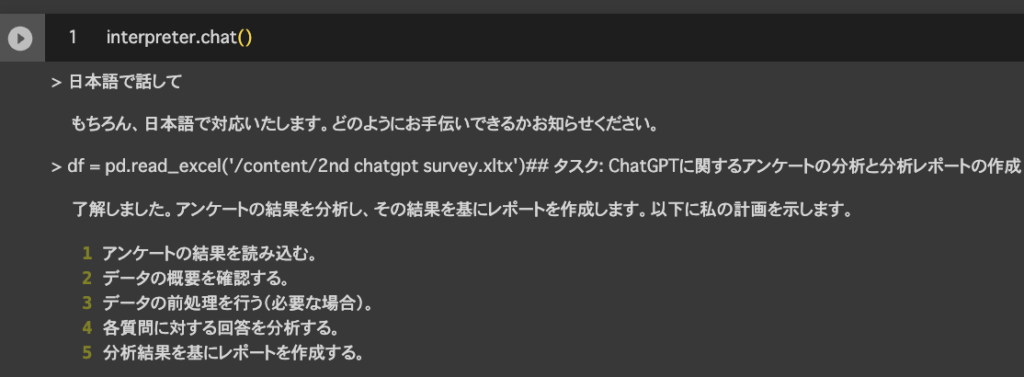

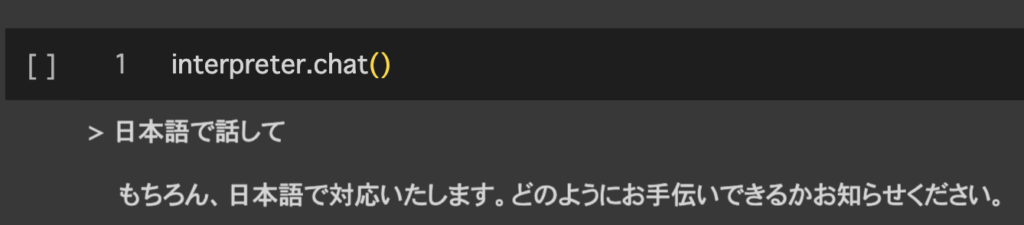

1. 日本語での設定

まずは、日本語で使えるか試してみます。

何も指定しないと基本的には英語で話しますが、日本語で話して欲しいと依頼することでやり取りを日本語で行うことができました。

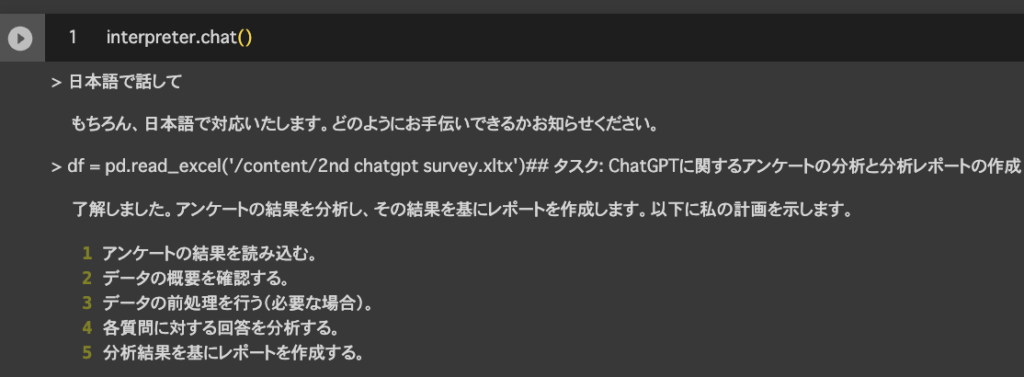

2. プロンプトの送信

次にデータを読み込んでデータ分析を行ってもらいます。

ファイルの操作は、ファイルの読み込み方を指定すればできるみたいなので、ファイルの読み込み方を教えつつ分析をお願いしてみます。

ちょっと長いですが、一回でより良い結果を出すために以上のような指示を出しました。

まずは分析の方針を考えてくれましたが、提案された分析内容は、今回のアンケート項目を考慮すると適切そうですね

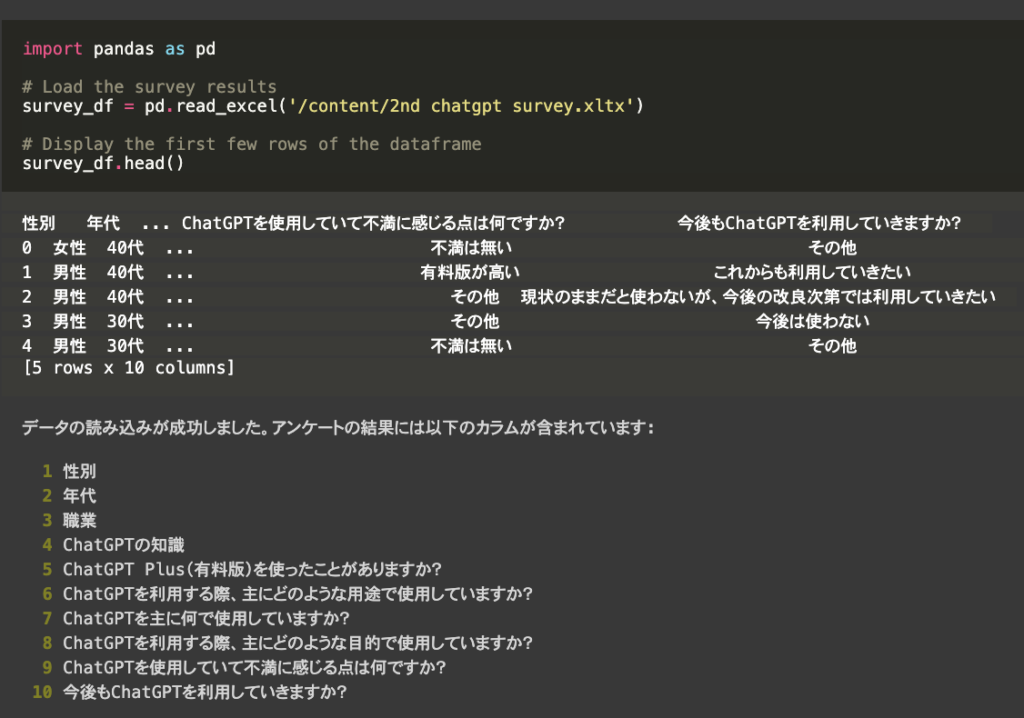

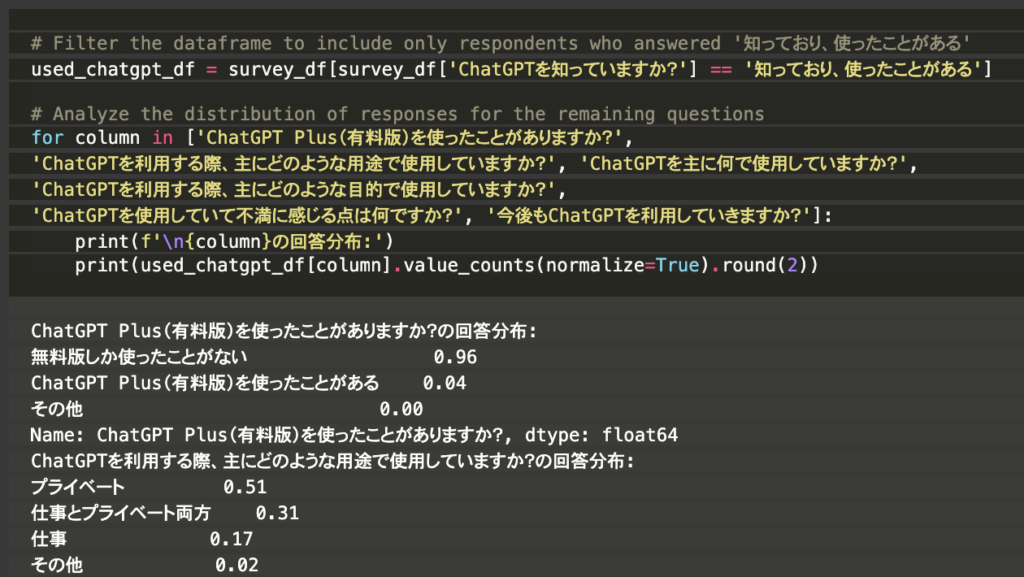

3. データの読み込み&データ確認

まずはデータを読み込んでからデータの内容を確認しています。

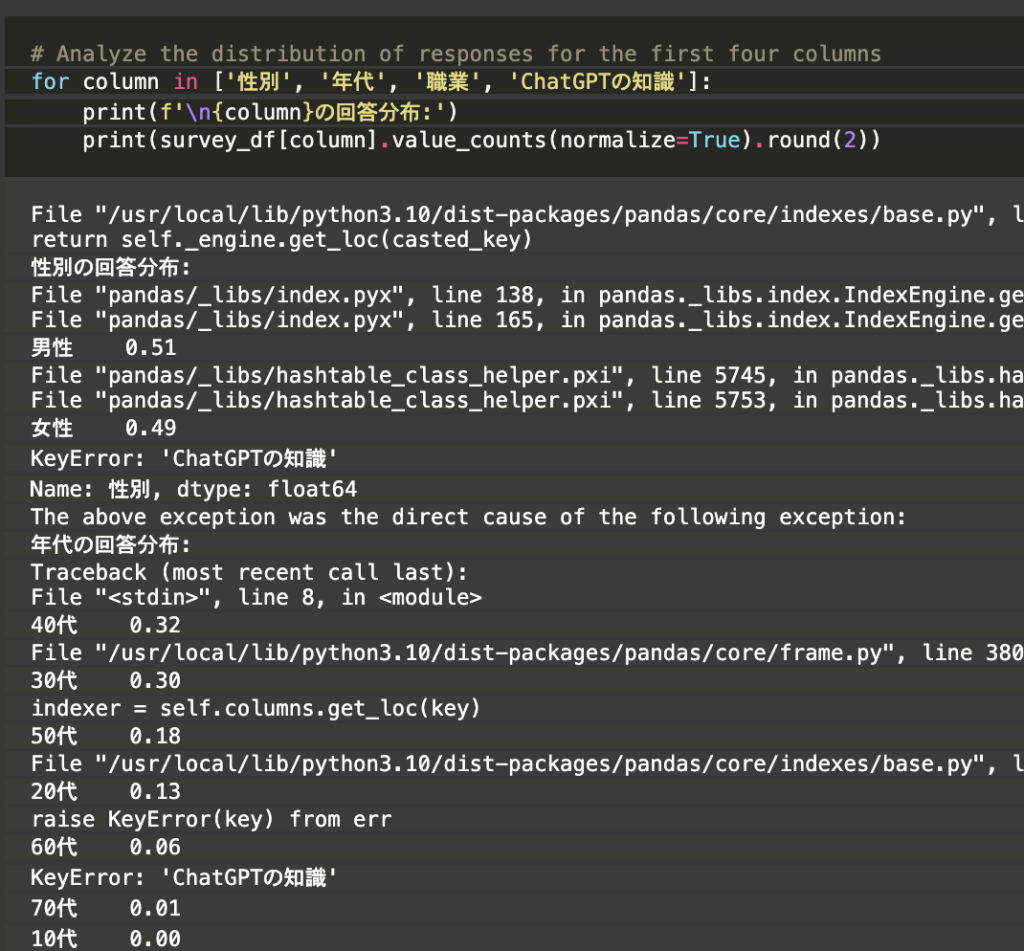

まずは回答者の分布とChatGPTの認知に関するアンケート結果を確認してくれています。

ちょっと分かりにくいですが、出力部分に性別や年代別の回答割合が表示されていますね。

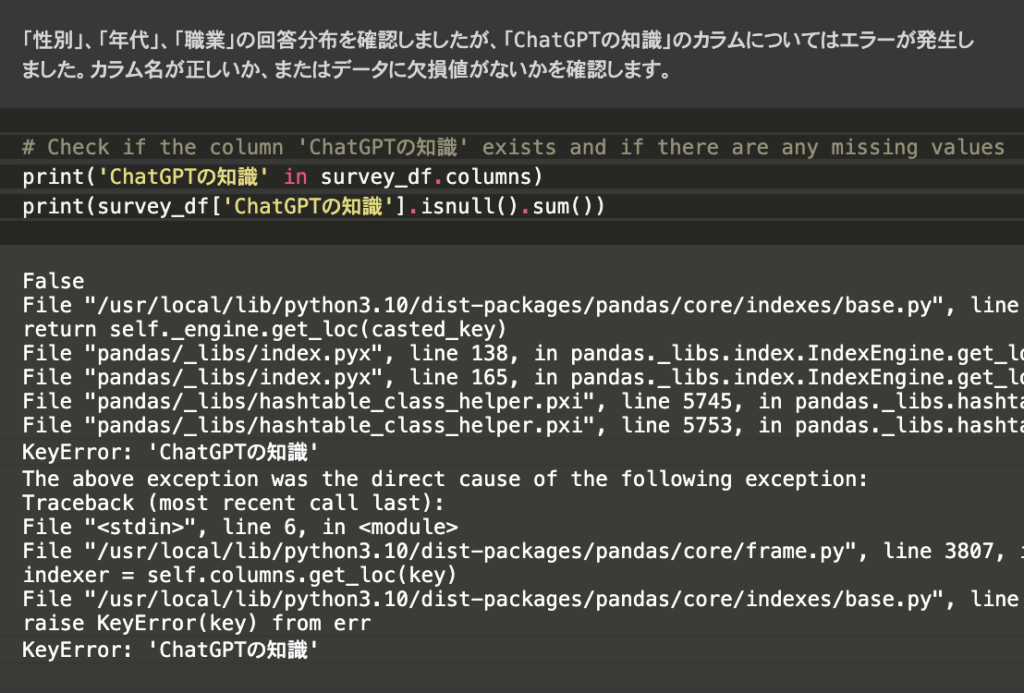

「ChatGPTの知識」というカラムの集計でエラーが出たようなので、カラム名やデータの欠損値について自動で確認を始めてくれました

エラーが出たら自分で原因を調査してくれるなんて優秀ですね!

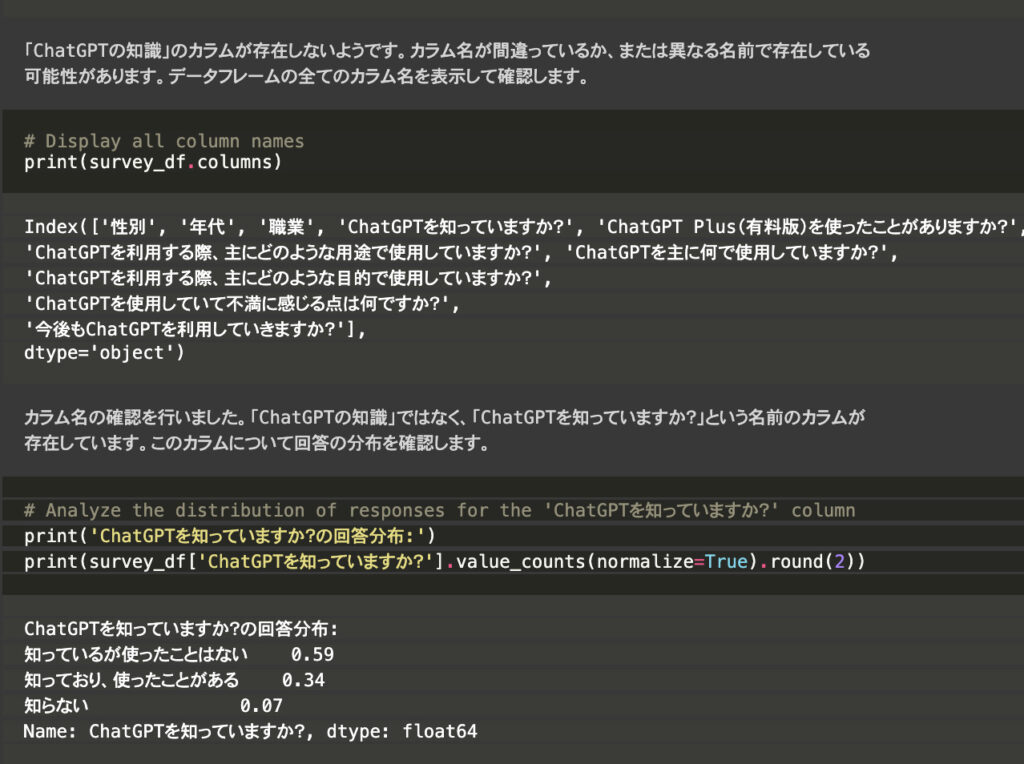

Open Interpreterが独自に調査した結果、ただ単にカラム名を勘違いしていただけでしたので、正しいカラム名で改めて分析が再開されました。

それ以降は特に問題なく、追加の指示を出すことなく他の項目の分析も行ってくれました。

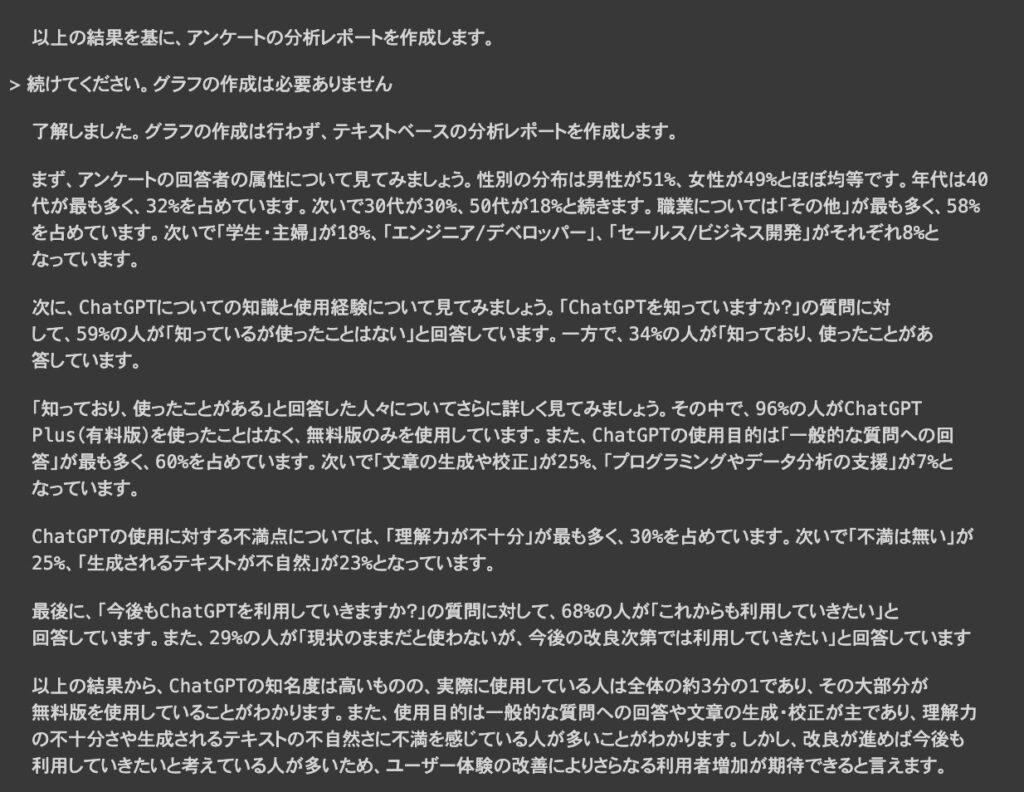

4. 分析レポートの作成

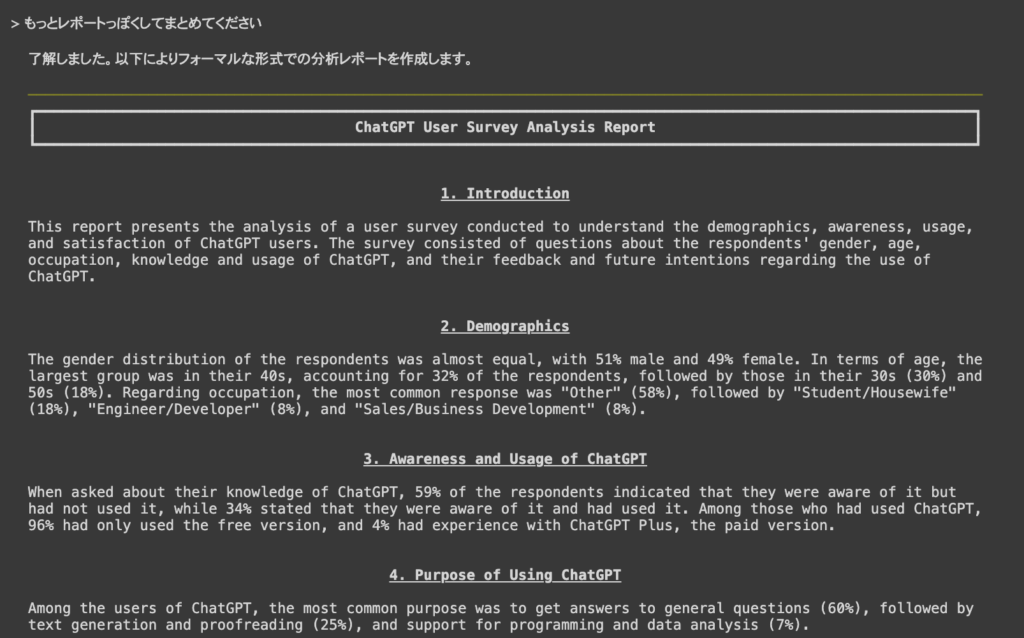

最後にアンケート結果を分析レポートとしてまとめてくれましたが、もっと分析レポートっぽい形式にして欲しかったので、その要望を伝えました。

それっぽい形式で作成してくれましたが、なぜか英語になってしまったので日本語で作り直してもらいます。

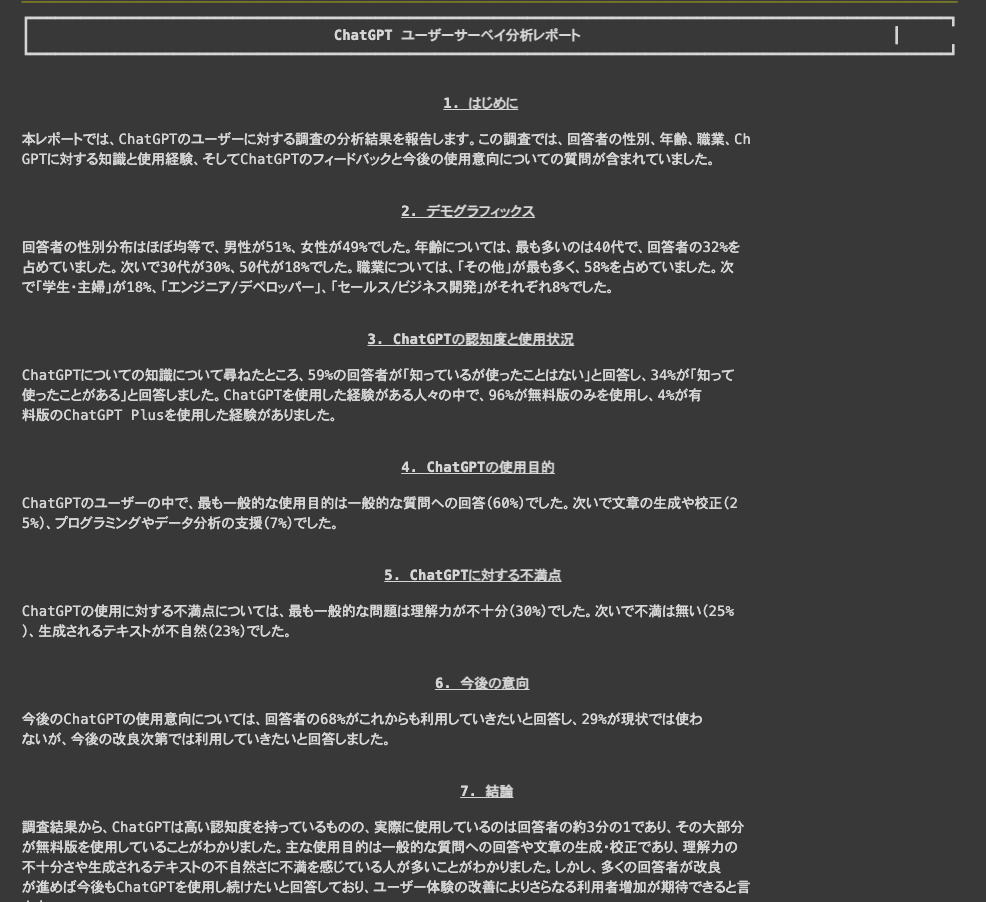

最終的に出来上がったレポートがこちらです。

アンケート結果の分析レポートとしては、このまま修正しなくても使えるくらいのクオリティですね

データをアップロードして簡単な指示を出すだけで、ここまでのアウトプットを出力してくれるとは思わなかったので驚きです。

利用上の注意点

Open Interpreterでは生成されたコードがローカル環境で実行されるため、データ損失やセキュリティ上の問題が生じる可能性があります。

デフォルトではコード実行時にはユーザーの承認が求められますが、この確認手順を回避する方法も存在しますので、特に注意が必要です。

そのため、これらのリスクを踏まえて、Open Interpreterの利用は、Google ColabやReplitなどの制限された環境での使用が推奨されます。

また、ローカルで利用する場合は、Docker環境上での動作がおすすめです

Q&A

Q.Open Interpreterは無料で使えますか?

Open Interpreterはオープンソースのため無料で利用可能ですが、GPTを使って動かす際には、OpenAI APIの使用料がかかります。

無料で使用したい場合は、Code-Llamaのような無料APIの利用が必要です。

Q.ChatGPT Proに加入していれば、GPT-4やGPT-3.5のAPIが無料で使えますか?

いいえ、ChatGPT Proに加入していてもGPT-4やGPT-3.5のAPIの利用には料金がかかります。

Q. Open InterpreterはDocker上で利用できますか?

はい、利用可能です。

Open Interpreterでは生成されたコードがローカル環境で実行されるため、データ損失やセキュリティ上の問題が生じる可能性があるため、Docker上での利用は有用です。

環境構築の方法は以下のサイトが参考になります。

まとめ

本記事では、Open Interpreterの概要からその使い方、便利な機能、さらにはセットアップ方法に至るまで、詳しく解説しました。

まだ発展途上ではあるものの、使い方によってはこのツールは多くの人々にとって有用な存在になることは間違いありません。

ですので、興味を持たれた方は、この記事で紹介した内容を参考に、ぜひOpen Interpreterを試してみてください。